El tercer problema -y no el menos relevante- sería: ¿ayudan los IHMs a limitar la carga de trabajo ligada a la introducción de datos?¿Cómo articular una verdadera cooperación hombre-sistema, estableciendo una relación de confianza entre ambos?

En los últimos veinte años hemos visto aparecer sistemas avanzados de ayuda a la operación, que ofrecen a quien interactúa con el sistema informaciones, estrategias, presentaciones gráficas, advertencias y alarmas que, en teoría, permiten al operador identificar y diagnosticar problemas, así como las acciones que deben emprender para resolverlos. La otra cara de la moneda es que los sistemas, para “ayudar”, necesitan conocer las variables que afectan al proceso y, sobre todo, saber no sólo lo que hace el operador, sino sus intenciones, lo que quiere hacer.

A mi entender, se trata de una de las grandes paradojas a las que se enfrentan los sistemas avanzados de interacción. Los sistemas pueden ofrecer ayuda y salvaguarda, dar consejos y pistas, actuar de forma autónoma evitando o reduciendo la carga cognitiva del operador humanos... ¡pero deben saber quién es el operador que tienen delante (qué sabe, para qué está capacitado), qué hace (p.e., en el caso de un controlador aéreo, el controlador deber decir al sistema lo que ya le ha dicho al piloto) y qué quiere hacer (para ofrecerle asistencia preventiva o precoz sobre las consecuencias de lo que va a hacer)!.

Tercera tendencia: aparición de sistemas multimodales que reciben la información que necesitan con muy bajo coste de interacción para el operador, con tasas de fallo de interpretación cada vez menores, lo que hace cada vez más fiable la división del trabajo entre seres humanos y máquinas.

Esta tendencia es, con toda seguridad, la más característica del tiempo que nos ha tocado vivir. Son muchas las líneas de investigación y los productos que buscan minimizar este coste de interacción, con el horizonte de naturalizar la interacción hasta límites insospechados. En este amplísimo punto podemos reseñar desde las conocidas tecnologías de reconocimiento de la voz, a todo un grupo de investigaciones que ya se encuentran en un estado de difusión hacia los productos de gran consumo, como son las tecnologías de interacción táctil.

Existen muchas razones para creer que estas formas de interacción táctil son la parada más inmediata en el largo camino de las tecnologías de interacción. No es gratuita la enorme aceptación que tienen estos sistemas táctiles de interacción ya que son coherentes con varios millones de años de evolución humana ligados al uso de las manos como herramienta.

Esto supone que prácticamente veremos desaparecer el ratón como dispositivo apuntador, ya que serán nuestros dedos los que mejor comuniquen nuestros actos y deseos a la máquina. Esto tampoco quiere decir que la mano no vaya a seguir conviviendo durante mucho tiempo con dispositivos que potencien su propia capacidad de interacción, pero pasarán a ser dispositivos auxiliares de la interacción táctil. La tecnología de interacción táctil produce una impresión real de reencuentro con la informática como una herramienta manual, lo que la hacer formar ya parte del bagaje de dispositivos que nos acompañan desde tiempo inmemorial, como el martillo o el cuchillo.

Es notable el avance que este sentido propone toda una corriente de investigación conocida como “inteligencia ambiental”. Para que se me entienda, un entorno (incluidos sus interfaces) serán “inteligentes” si son capaces de adaptarse al usuario de dicho entorno.

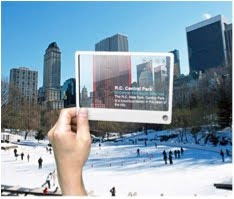

Un ejemplo muy sencillo: mi cocina deberá “saber” o “detectar” que mi hijo de seis años está dentro de ella y prohibirá al horno que le deje encenderlo (y además dejará constancia y me informará de este intento por su parte). Sin embargo a mi sí que me permitirá hacerlo y además me ofrecerá la posibilidad de consultar un dispositivo visual en el que simulará en realidad aumentada, mediante un holograma en 3D, el aspecto que va a tener el plato que me dispongo a cocinar, o me sugerirá alternativas si no dispongo de alguno de los ingredientes (y me dirá si el supermercado más cercano dispone de ellos).

Un ejemplo muy sencillo: mi cocina deberá “saber” o “detectar” que mi hijo de seis años está dentro de ella y prohibirá al horno que le deje encenderlo (y además dejará constancia y me informará de este intento por su parte). Sin embargo a mi sí que me permitirá hacerlo y además me ofrecerá la posibilidad de consultar un dispositivo visual en el que simulará en realidad aumentada, mediante un holograma en 3D, el aspecto que va a tener el plato que me dispongo a cocinar, o me sugerirá alternativas si no dispongo de alguno de los ingredientes (y me dirá si el supermercado más cercano dispone de ellos). Ni que decir tiene que todo esto ofrece posibilidades enormes para que los operadores de una instalación industrial puedan visitar la instalación sin ir a ella, obtener información de operación instantáneamente, detener un bomba simplemente con un gesto ante la pantalla, o introducir una temperatura o una velocidad señalando con un dedo mientras se ordena verbalmente el dato al sistema.

No hay comentarios:

Publicar un comentario